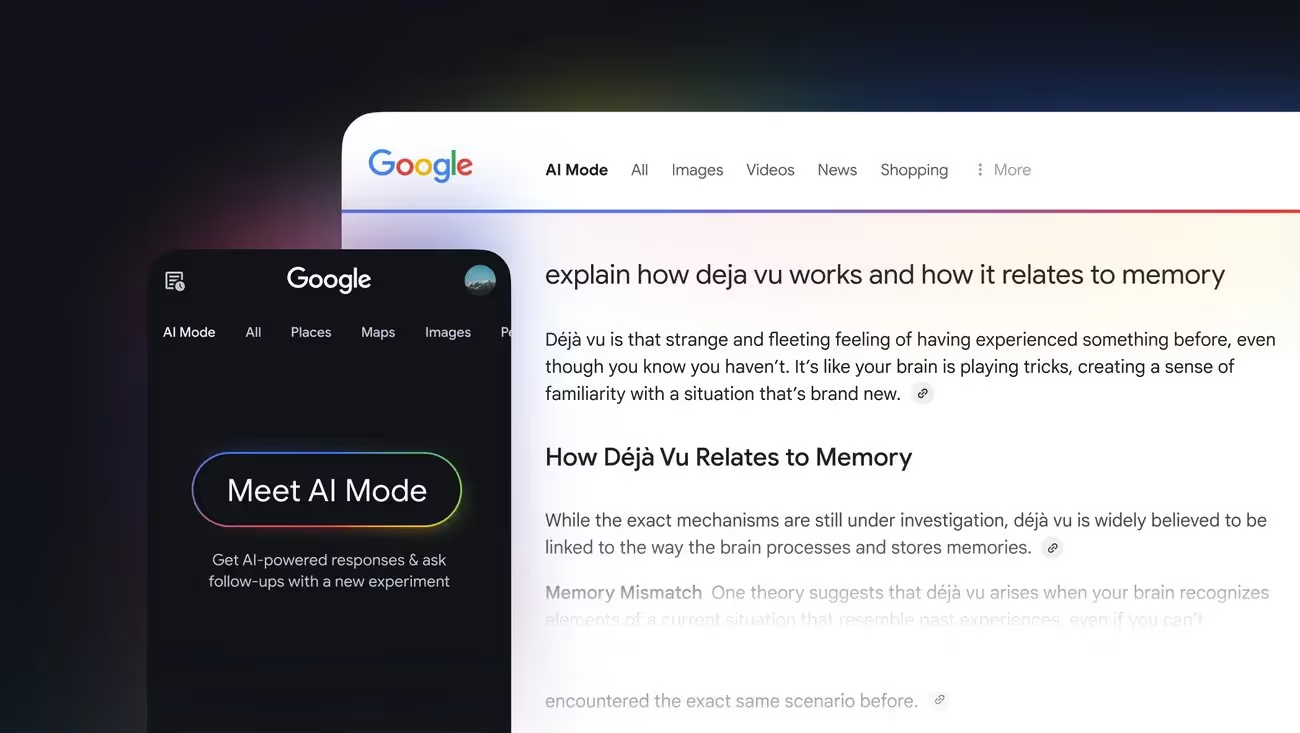

Google vient de déployer le mode IA, et je suis assis ici avec des sentiments mitigés. À première vue, c'est impressionnant. Les requêtes qui étaient auparavant utilisées par les moteurs de recherche (longues, compliquées et conversationnelles) sont désormais traitées avec clarté. Le système ne se contente pas de pointer vers des liens ; il essaie de vous répondre directement, en transformant vos recherches en conversations aller-retour.

Mais pour le référencement, la situation est différente. Ce qui caractérise la visibilité guidée depuis des décennies ne s'applique pas pleinement lorsque votre contenu est séparé, reformulé et parfois masqué dans une réponse générée par l'IA. Vous pouvez tout faire correctement (schéma, explorabilité, autorité) sans savoir comment ni si votre travail se présente. Cette incertitude constitue le véritable changement. Et même si beaucoup le considèrent encore comme « juste du référencement », ignorer ce qui se passe risque de laisser le terrain au dépourvu. Voyons comment fonctionne le mode IA et en quoi consiste ce battage médiatique.

Qu'est-ce que le mode IA de Google ?

Le mode IA est le nouveau bouton de Google situé juste à l'intérieur de la barre de recherche et, à première vue, cela ressemble à une mise à jour discrète. Mais cliquez dessus et l'expérience changera. Au lieu de faire défiler une page de liens bleus, vous obtenez une réponse directe provenant de plusieurs sources. Les réponses sont plus longues, plus conversationnelles et, dans de nombreux cas, étonnamment efficaces pour gérer des requêtes compliquées qui auraient embrouillé la recherche traditionnelle.

Pensez à vous demander : « Quelles plantes peuvent supporter un coin ombragé et argileux dans lequel les enfants ne cessent de courir ? » La recherche classique créerait des articles de blog et des discussions sur le forum éparpillés. Le mode IA, quant à lui, analyse les détails, extrait différentes références et renvoie quelque chose de cohérent. Les sources sont toujours affichées, mais souvent cachées, et toutes les réponses ne mènent pas directement à un clic.

Pour les recherches commerciales, telles que la comparaison de sérums de soins de la peau ou l'achat de voitures, la fonctionnalité peut faire apparaître des produits ou des options sans diriger le trafic directement vers des sites Web. À l'heure actuelle, Google n'a pas étroitement lié le mode AI au comportement d'achat, mais des démonstrations lors de Google I/O laissaient entendre que c'était à venir. Les publicités, les intégrations de produits et même les actions d'achat pourraient bientôt être intégrées à cette expérience.

Alors que le mode IA semble expérimental aujourd'hui, il marque un changement dans le fonctionnement fondamental de la recherche. Au lieu de simplement répertorier ce qui existe, Google agit davantage comme un éditeur, qui décide ce qu'il doit afficher, ce qu'il faut fusionner et comment formuler la réponse finale.

Comment fonctionne le mode AI

La façon la plus simple de penser au mode IA est que Google ne vous répond pas directement. Il divise votre requête en plusieurs requêtes plus petites, puis assemble les résultats. Ce processus en coulisse est appelé « query fan-out ». Vous tapez une question, et au lieu de lancer une seule recherche, le système exécute un lot complet en arrière-plan. Chacune aborde un angle légèrement différent de votre demande, puis le modèle les regroupe en une seule réponse.

C'est là que les choses deviennent intéressantes. Contrairement à Perplexity ou à d'autres outils de recherche basés sur l'IA qui vous montrent les recherches masquées, Google garde ses sous-requêtes invisibles. En tant que spécialistes du marketing, cela signifie que nous ne pouvons pas voir quels chemins il a empruntés. Un cycle peut vérifier les comparaisons de produits, un autre peut vérifier les prix et un autre peut recueillir des avis. Mais tout cela est caché derrière le rideau.

C'est pourquoi les personnes qui ont expérimenté Gemini ont remarqué une astuce : en élargissant sa « pensée », vous pouvez parfois voir ces recherches d'arrière-plan. Bien qu'il ne reflète pas exactement le mode IA, il est suffisamment proche pour donner des indices. Pour le référencement, c'est un signal. Si Google divise les requêtes en sous-sujets, notre contenu doit dépasser ces limites, en répondant non seulement à la question principale, mais à toutes les questions connexes qui pourraient en découler. Donc, la version courte : le mode IA ne se limite pas à la recherche et à l'IA. Il s'agit d'un processus en couches qui consiste à casser, récupérer et reconstruire, et le résultat que vous voyez n'est que la surface.

Qu'est-ce que AI SEO de toute façon ?

L'expression « IA SEO » est souvent utilisée, souvent comme s'il s'agissait simplement d'une nouvelle image de marque de ce que nous faisons depuis deux décennies. Mais ce point de vue passe à côté de l'essentiel. SEO traditionnel a été construit sur un paradigme de récupération : faites en sorte que votre contenu soit explorable, indexable et suffisamment fiable pour être classé. Si vous avez bien fait ces choses, votre page apparaissait dans les résultats, plus ou moins intacte.

Le mode IA rompt cette chaîne. Il ne fait pas apparaître des pages entières comme le faisaient les moteurs de recherche. Au lieu de cela, il découpe le contenu en passages, en réécrit des parties et décide de vous citer ou non. Ce qui compte, ce n'est pas seulement que votre contenu soit disponible, il doit être rédigé de manière à ce que les modèles puissent saisir, raisonner et intégrer dans une réponse assemblée.

Cela signifie que le « référencement par IA » ne consiste pas à intégrer plus de mots clés ou en recherchant les mêmes anciens rapports de classement. Il s'agit d'améliorer la pertinence à un niveau plus profond : structurer les passages, intégrer des faits clairs et fournir un contexte qu'un système d'IA peut réutiliser dans sa logique. Le travail consiste moins à être trouvé directement par les utilisateurs qu'à être utile à la machine qui sert d'intermédiaire dans la conversation.

Le référencement est-il optimisé pour le mode IA ?

Pour être honnête, non, le référencement n'est pas préparé pour le mode IA. La discipline repose toujours sur des modèles de recherche clairsemés tels que TF-IDF et BM25, fondements du classement par mots clés. AI Mode ne pense pas en ces termes. Il fonctionne sur une extraction dense, où chaque requête et chaque passage sont convertis en intégrations et comparés dans un espace vectoriel. C'est un jeu complètement différent, et nos outils actuels ne sont pas à la hauteur.

Aujourd'hui, il y a toujours des chevauchements. Les pages bien classées dans les SERP classiques apparaissent souvent dans les réponses du mode AI. Mais à mesure que le système s'intéresse de plus en plus à la personnalisation et à la mémoire, ce chevauchement diminue. Deux personnes peuvent saisir la même requête et voir des résultats différents, en fonction de leur historique et de leur profil. Le suivi des classements traditionnel suppose un ensemble de résultats universel, qui n'existe pas en mode IA.

Vient ensuite le problème des clics. Le mode AI répond souvent à la requête directement sur la page. Votre contenu peut contribuer à cette réponse, mais les utilisateurs n'ont pas besoin de cliquer pour accéder à votre site. D'un point de vue commercial, cela signifie que les impressions se produisent de manière invisible : vous contribuez sans preuve de trafic. Les rapports indiquent une diminution du nombre de visites, même si votre travail est au cœur de ce que voient les utilisateurs.

Donc, non, le référencement tel qu'il est n'est pas optimisé pour le mode IA. Les tâches classiques telles que l'exploration, l'indexation et les signaux d'autorité sont toujours importantes, mais ce sont des enjeux de table. Ce qui fait défaut, ce sont des compétences en ingénierie des passages, en mesure de l'alignement sémantique et en suivi des citations là où les clics ne se produisent jamais. Jusqu'à ce que ces écarts soient comblés, le secteur reste à la traîne.

L'avenir de la recherche est multimodal

L'un des principaux changements apportés au mode AI est que la recherche ne se limite plus au texte. Le système peut traiter le langage, la vidéo, l'audio et les images dans le même pipeline de récupération. Cela signifie qu'une réponse à votre question peut tout aussi bien être extraite d'une transcription de podcast, d'une vidéo de démonstration de produit ou d'un graphique que d'un article de blog. Pour Google, peu importe le format dans lequel le contenu a commencé, la question est de savoir s'il comble une lacune dans la réponse.

Cela pose un nouveau problème pour le référencement. Historiquement, vous pouviez adapter votre stratégie aux requêtes textuelles et optimiser les pages en conséquence. Aujourd'hui, le champ s'est élargi. Une citation de podcast peut remplacer ce que votre article aurait pu dire. Un schéma pourrait remplacer votre explication. Plus difficile encore, Google peut remixer les formats multimédia, en transformant un graphique en texte ou un texte en liste à puces, sans vous pointer du doigt.

Le principal point à retenir est que le succès en mode IA ne se limite plus au classement des pages Web. Il s'agit de créer des écosystèmes de contenu dans de multiples formats afin que, quelle que soit la réponse choisie par le système, votre contenu figure dans le pool. Il peut s'agir de vidéos transcrites, de podcasts structurés ou de données visuelles que les machines peuvent analyser.

La recherche multimodale est la direction que prend la recherche, ce qui signifie que le référencement doit cesser de considérer le contenu comme des « pages » et commencer à le considérer comme des actifs qui peuvent être réutilisés, recomposés et cités d'une manière que nous ne contrôlons pas totalement.

Que disent et prédisent les ingénieurs de Google ?

Les ingénieurs à l'origine du mode IA n'hésitent pas à savoir où cela va nous mener. Lors de Google I/O, lors des panels de suivi et même lors de discussions privées avec les référenceurs, leur message était cohérent : le mode IA n'est pas une expérience temporaire. C'est la nouvelle orientation de la recherche, et de nombreuses fonctionnalités qui semblent nouvelles aujourd'hui seront intégrées à l'expérience par défaut plus tôt que prévu.

Alors, que disent-ils exactement, et que devons-nous en tirer ? Voici ce que :

Google veut réduire les « coûts Delphiques »

L'une des expressions qui est revenue dans les conversations est « coûts delphiques », en référence à la charge cognitive à laquelle les utilisateurs sont confrontés lorsqu'ils doivent rassembler des réponses à plusieurs requêtes. Dans le passé, vous faisiez plusieurs recherches, collectiez des liens et obteniez votre propre conclusion. Google souhaite que le mode AI gère ce travail d'assemblage. La vision est claire : moins de recherches par session, mais des réponses plus riches en une seule interaction.

Le trafic n'est pas leur priorité

Alors que la communauté SEO s'inquiète des clics et de la visibilité, les ingénieurs considèrent le trafic presque comme un effet secondaire. Leur objectif est de répondre aux besoins d'information dans la page de résultats. Cela signifie que votre contenu peut apporter la réponse mais ne pas toujours attirer la visite. Cette évolution explique pourquoi les reportages ne semblent pas fiables : des citations peuvent apparaître, mais le trafic baisse. Du point de vue de Google, ce n'est pas un échec, c'est un progrès.

La personnalisation s'approfondit

L'équipe a également fait preuve de franchise en ce qui concerne la personnalisation. Le mode AI ne s'adapte pas seulement à la requête, il s'adapte à l'utilisateur. Les intégrations créées à partir de l'historique des recherches, des données de localisation et des interactions entre Gmail, Maps et YouTube influencent ce qui apparaît. Deux personnes dans la même ville peuvent saisir la même requête et obtenir des réponses différentes. Le suivi des classements déconnecté n'en tiendra pas compte, c'est pourquoi les ingénieurs laissent entendre discrètement que les rapports sur le référencement auront besoin d'une nouvelle base.

La publicité et le commerce entrent en scène

Un autre thème est le commerce. À I/O et plus tard à Google Marketing Live, des démonstrations ont montré comment AI Mode pouvait recommander des produits ou même effectuer des transactions. Les ingénieurs ont confirmé que des expériences étaient en cours avec des campagnes pMax et des données Shopping Graph alimentant le mode IA. Pour les marques, cela signifie que les placements pilotés par l'IA finiront par avoir autant d'importance, sinon plus, que les publicités traditionnelles dans les SERP classiques.

Où cela en est-il du référencement ?

Lorsqu'on leur a demandé quel rôle jouerait le référencement dans ce futur, les ingénieurs n'ont pas donné de réponse claire. Ils ont répété des conseils familiers (santé technique, qualité du contenu, signaux clairs) mais n'ont pas proposé de nouveaux modes de jeu. Cette ambiguïté n'est pas fortuite. Cela reflète cette évolution : le référencement fait toujours partie du mix, mais les règles de base sont en train de changer. Google optimise en fonction du raisonnement et du contexte utilisateur, et non en fonction de la diffusion des clics.

Le mode AI utilise une architecture contextuelle en couches

Le mode IA n'est pas un pipeline unique de requêtes à réponses. Il s'agit d'un système en couches dans lequel le contexte est mémorisé, les requêtes sont multipliées, les passages sont récupérés, puis la réponse finale est assemblée. Chaque couche est importante, car elle modifie la manière dont les informations sont sélectionnées et réécrites. Voici ce que vous devez savoir pour comprendre le fonctionnement du mode IA :

Couche de contexte

Le mode IA ne traite pas vos recherches de manière isolée. Il conserve un état de fonctionnement qui reflète les requêtes récentes, les paramètres de l'appareil, les données de localisation et même les signaux provenant d'autres applications Google. Cet état définit la façon dont votre prochaine question est interprétée. Si vous posez une question sur « l'autonomie de Seattle à Las Vegas » après avoir examiné les VUS électriques, le mode AI ne redémarre pas, il poursuit le même fil.

Pour le référencement, cela signifie que deux utilisateurs peuvent taper les mêmes mots et déclencher des résultats différents, car leur arrière-plan façonne la façon dont Google interprète l'intention. Le contexte n'est plus facultatif ; il est intégré à la recherche dès le début.

Couche d'extension de requêtes

Une fois le contexte défini, Google diffuse la requête vers l'extérieur. Le système génère plusieurs recherches masquées, chacune portant sur une partie de l'intention initiale : prix, avis, comparaisons de fonctionnalités et sujets connexes. On ne les voit pas, mais ils se produisent à chaque fois sous le capot.

C'est là que les expériences de Gemini ont donné un aperçu aux spécialistes du marketing : en élargissant ses pistes de raisonnement, vous pouvez parfois jeter un coup d'œil à ces sous-requêtes. Ils révèlent à quel point le système est granulaire, en divisant une question générale en une demi-douzaine de séries d'enquêtes plus petites.

Couche de récupération

À partir de là, le mode AI ne classe pas les pages entières comme le faisait la recherche traditionnelle. Il évalue au niveau du passage. Un seul paragraphe caché à mi-chemin d'un article peut être considéré comme plus pertinent que le titre ou les premières lignes.

Il s'agit d'un changement majeur pour le référencement. Cela signifie que l'optimisation au niveau de la surface (titres, en-têtes, balises méta) ne va pas loin. Les passages de votre contenu doivent être suffisamment clairs et autonomes pour que Google puisse les extraire et les ajouter à une réponse sans avoir besoin du reste de la page pour le contexte.

Couche de synthèse

La dernière étape est la synthèse. Les passages récupérés sont réécrits, fusionnés et parfois réorganisés pour former ce qui semble être une réponse fluide. Certaines citations apparaissent, souvent mises de côté. D'autres disparaissent complètement. Pour l'utilisateur, cela ressemble à une seule voix, mais en réalité, il s'agit de fragments assemblés à partir de plusieurs sources.

Cette réécriture est à l'origine de la plupart des frustrations liées au référencement. Vous pouvez fournir la réponse sans être mentionnée, ou votre marque peut apparaître comme une citation parmi d'autres, sans aucune garantie de clics. Du point de vue de Google, l'objectif n'est pas d'être équitable envers les éditeurs, mais de fournir une réponse qui soit cohérente et fiable.

Pourquoi c'est important

La compréhension de ces couches change notre façon de concevoir la visibilité. Le référencement classique partait du principe que votre page était l'unité concurrente. En mode AI, l'unité est un passage. Il ne suffit pas de vous classer : vous devez créer un contenu qui survivra à la division, à la réinterprétation et au réassemblage pour en faire un contenu qui ne fera que vous pencher dans votre direction.

Mode IA et traitement et synthèse LLM en plusieurs étapes

Lorsque les gens entendent le « mode IA », ils imaginent souvent un seul modèle en train de cracher une réponse. La réalité est plus complexe. Google ne s'appuie pas sur un seul passage dans un modèle de langage volumineux. Il exécute plusieurs étapes de traitement avant de voir un résultat.

La première étape est celle de l'interprétation. Le modèle reformule votre requête, la nettoie et l'aligne sur les modèles d'intention connus. À partir de là, on passe à l'expansion : création des sous-requêtes qui seront utilisées pour extraire des passages du Web et d'autres sources. C'est l'étape des fans dont nous avons parlé plus tôt.

Une fois les passages revenus, une autre étape commence. Au lieu de les lancer directement dans une réponse, le système effectue ce que les ingénieurs appellent la « synthèse ». Le modèle pèse les passages, vérifie s'il y a des conflits et décide quelles pièces conserver. Il les réécrit ensuite en une seule voix. Considérez-le comme un bureau de rédaction où différents rédacteurs remettent des brouillons, et l'éditeur choisit et peaufine ce qui a du sens.

À cela s'ajoute souvent une étape de raisonnement, au cours de laquelle le modèle explique sa chaîne de pensée en interne. Vous ne voyez pas ce raisonnement, mais il guide la façon dont les preuves sont classées et formulées. Ce n'est qu'après ces vérifications que le texte apparaît en tant que réponse du mode AI.

Pour le référencement, le point à retenir est que la visibilité ne dépend pas d'une seule extraction. Il s'agit d'un pipeline en plusieurs étapes dans lequel chaque couche décide si votre contenu survivra jusqu'à la version finale.

Extraction dense et sémantique au niveau des passages en mode IA

C'est là que les choses deviennent techniques, mais restez avec moi : c'est plus important pour le référencement que la plupart des gens ne le pensent. La recherche Google classique reposait sur une recherche fragmentaire. Pensez à la correspondance de mots clés. Vous avez saisi « meilleur CRM pour les startups », Google a recherché des pages contenant ces termes exacts, puis les a classées en fonction de signaux tels que les backlinks et l'autorité.

Le mode IA ne pense pas comme ça. Il fonctionne en mode de récupération dense. Au lieu de simplement faire correspondre des mots, il convertit votre requête en un vecteur numérique, essentiellement une empreinte mathématique du sens. Ensuite, il recherche les passages sur le Web avec les empreintes digitales les plus proches des vôtres dans l'espace vectoriel.

C'est pourquoi les mots clés ne garantissent plus à eux seuls la visibilité. Le système lit pour le sens, pas seulement pour les allumettes. Une page contenant l'expression « CRM abordable » pourrait être remplacée par une autre qui ne mentionne jamais le mot « abordable » mais qui traite en profondeur des niveaux de tarification, des remises et des conditions contractuelles.

Et voici le hic : il n'y a plus de pages entières en compétition. Ce sont des passages. Google n'a pas besoin de votre article de blog de 2 000 mots. Il se peut qu'il n'obtienne qu'une section de 80 mots enfouie au milieu.

Qu'est-ce que cela signifie pour le contenu ?

- Écrivez dans des passages indépendants. Chaque bloc doit être autonome avec un contexte clair.

- Couvrez les voisins sémantiques. Ne vous contentez pas de répéter des mots clés : abordez les concepts connexes auxquels le modèle peut renvoyer.

- Pensez à des unités plus petites. Les paragraphes sont la monnaie d'actualité, pas seulement les pages.

Mode AI : mémoire ambiante et interfaces adaptatives

Google ne se contente pas de créer un champ de recherche plus intelligent. Il construit un système de recherche qui mémorise. Les ingénieurs appellent cela une « discussion dynamique », et elle est alimentée par ce que les brevets décrivent comme mémoire ambiante.

Chat dynamique et mémoire ambiante

Google Classic a oublié. Chaque recherche était réinitialisée. Le mode AI fait avancer la mémoire. Cette mémoire n'est pas simplement votre dernière requête ; il s'agit d'une représentation compressée de votre comportement actuel : sujets que vous avez recherchés, liens sur lesquels vous avez cliqué, et même ce que Google connaît grâce à Gmail, Maps ou YouTube. Ils ne sont pas stockés sous forme de chaînes de texte mais sous forme d'intégrations : des vecteurs denses qui capturent vos modèles à long terme. Considérez-les comme des empreintes mathématiques de votre intention.

Deux personnes peuvent taper les mêmes mots et obtenir des réponses très différentes, non pas parce que la requête n'est pas claire, mais parce que le système les « connaît » différemment. Ce n'est pas de la science-fiction. C'est ce qui se cache sous le capot en ce moment.

L'intégration des utilisateurs en action

Voici comment ces intégrations utilisateur façonnent le pipeline d'AI Mode :

- Interprétation des requêtes — l'intention est classée différemment en fonction de votre historique.

- Génération de requêtes synthétiques — le fan-out donne la priorité aux sous-requêtes les plus proches de votre profil.

- Récupération des passages — des changements de classement en fonction de l'affinité avec votre comportement passé.

- Synthèse des réponses — le format lui-même (liste, graphique, vidéo, carrousel) s'adapte à vos préférences.

Interfaces adaptatives

L'interface s'adapte également. La démo de l'interface utilisateur personnalisée de l'année dernière faisait allusion à ce qui est désormais visible en mode IA : parfois, les réponses arrivent sous forme de puces, d'autres fois sous forme de prose fluide, ou même sous forme de carrousels et de graphiques. Ce n'est pas un hasard. Un modèle en aval prédit le format qui répondra le plus rapidement à la requête, en combinant récupération et présentation.

Ingénierie de pertinence

Cela réécrit les règles. Vous n'optimisez plus uniquement pour les mots clés ou même pour les pages complètes. Vous concevez des passages qui peuvent survivre dans un système probabiliste où la visibilité dépend à la fois de l'alignement sémantique et alignement du profil. Suivi des classements déconnecté ? Inutile Chaque réponse est filtrée par le biais d'une intégration utilisateur.

Si vous voulez participer à une compétition, le playbook passe à :

- Influencez les modèles de recherche grâce à l'image de marque au-delà de la recherche

- Rédigez des passages sémantiquement riches et structurés pour une réutilisation du LLM.

- Anticipez les requêtes cachées auxquelles votre contenu doit répondre.

- Optimisez pour plus de clarté au triple niveau (entité, attribut, relation).

- Testez grâce à des profils sélectionnés plutôt qu'à un suivi de classement générique.

Découpage des requêtes en mode AI

Le mode IA ne se contente pas de « répondre » à votre question. Il s'y développe. C'est ce que Google appelle ventilateur de requêtes, et c'est le moteur qui permet au mode IA de récupérer le contenu. Au lieu de traiter votre requête comme une recherche unique, il la multiplie en une constellation de sous-requêtes synthétiques, chacune explorant un angle différent de votre intention.

C'est pourquoi le mode AI semble plus précis que la recherche classique : il ne répond pas un question. Il répond à celle que vous avez posée et à la douzaine que vous n'avez pas articulée mais sous-entendue.

Comment fonctionne Query Fan-Out

Au cœur se trouve une phase d'expansion incitée. Un LLM comme Gemini est chargé de réécrire votre requête selon différentes dimensions :

- Diversité des intentions — réécritures comparatives, décisionnelles ou exploratoires

- Variation lexicale — synonymes, paraphrases, modifications de phrasé

- Réécritures d'entités — échanger ou restreindre les marques, les fonctionnalités ou les catégories de produits

Les brevets (« Systems and methods for prompt-based query generation for diverse retrieval ») montrent qu'il ne s'agit pas d'une hallucination aléatoire. Il s'agit d'une incitation structurée intégrant un raisonnement, ce que les ingénieurs appellent parfois une « chaîne de pensée basée sur les réponses rapides ».

Types de requêtes synthétiques

Le processus de ventilation génère différentes classes de requêtes :

- Requêtes associées — voisins thématiques (« meilleurs VUS hybrides » à partir de « meilleur SUV électrique »)

- Requêtes implicites — besoins déduits (« Les véhicules électriques avec la plus longue autonomie »)

- Requêtes comparatives — des instructions de décision (« Tesla Model X contre Rivian R1S »)

- Requêtes récentes — contextuelle à partir de votre session (« Rabais sur les véhicules électriques à New York » → « meilleur SUV électrique »)

- Requêtes personnalisées — tiré d'intégrations (« Véhicules électriques avec des sièges de 3e rangée près de chez moi »)

- Reformulations — des réécritures pures (« quel est le meilleur SUV électrique ? »)

- Expansions d'entités — des swaps plus étroits ou plus larges (« Avis sur la Volkswagen ID.4 »)

Chaque requête synthétique est acheminée vers le système de recherche dense de Google, qui extrait des passages candidats qui pourraient autrement être invisibles si vous ne suiviez que le terme principal.

Filtrage et diversification

Google ne se contente pas de répondre à toutes les requêtes des fans. Le système filtre en fonction de la couverture, garantissant :

- Catégories d'intentions multiples (transactionnelles, informationnelles, hédoniques)

- Différents types de contenus (graphiques, critiques, didacticiels, définitions)

- Pas de surajustement à la même « zone » sémantique

Cela rend la synthèse finale d'AI Mode plus complète, car elle est littéralement extraite d'un corpus personnalisé construit autour de votre espace de requête étendu.

Pourquoi les référenceurs interprètent mal les premiers aperçus de l'IA

Lorsque AI Overviews est apparu pour la première fois, les référenceurs pensaient que Google « tirait parti du plus profond des SERP ». C'est plus probable ? Cela n'atteignait pas vers le bas—il atteignait à travers. Les requêtes des fans concernaient du contenu bien classé pour des requêtes totalement différentes qui ne semblaient pas liées à celle saisie.

Cela change la donne : suivre le classement d'un seul mot clé ne signifie pas grand-chose. Vous pourriez vous classer #1 pour « meilleure assurance auto » mais perdez quand même face à une personne classée #4 pour une requête de fan comme « GEICO contre Progressive pour les nouveaux parents. »

Une chaîne de pensée basée sur les réponses

Les brevets de Google nous donnent un aperçu rare : les chaînes de raisonnement ne sont pas qu'une astuce de salon. Il s'agit d'un système conçu pour diviser une requête en étapes, vérifier ces étapes, puis les assembler pour obtenir une réponse. C'est ce que signifie réellement « chaîne de pensée basée sur la rapidité ».

Au lieu de traiter les requêtes comme une requête unique, le mode IA suit un raisonnement intermédiaire. Il fait une pause pour réfléchir. Cela décompose l'intention. Il valide ensuite la logique de sa propre sortie.

Comment fonctionnent les chaînes de raisonnement

- Étapes intégrées à la bande — généré dans le flux LLM (comme les instructions classiques en chaîne de pensée).

- Étapes hors bande — créé ailleurs dans le pipeline, puis réinjecté dans la synthèse.

- Chaînes hybrides — en croisant les deux voies : guidage de la recherche, reclassement et même filtrage des citations.

Cela est important car Google ne répond pas par « un seul clic ». C'est construire des échafaudages. Si votre contenu ne rentre pas dans l'un de ces échafaudages, vous ne serez même pas en lice.

Vous devriez l'imaginer de cette façon : le mode IA ne demande pas « quelle page se classe #1 ? » mais « quel passage m'aide à remplir l'étape de raisonnement #3 de cette chaîne logique ? » C'est là la grande différence.

Raisonner tout au long du pipeline

Si vous avez suivi de près le mode IA de Google, vous savez déjà qu'il ne s'agit pas uniquement de récupération. Ce qui le distingue, c'est le raisonnement. Google ne se contente pas d'extraire des documents et de les remixer ; il réfléchit activement à chaque étape. Le brevet « Réglage précis des modèles appris par machine à l'aide d'étapes de raisonnement intermédiaires » nous donne une idée de la façon dont cela fonctionne. Il décrit chaînes de raisonnement—des séquences structurées d'inférences qui relient une requête à une réponse finale.

Considérez-les comme des échafaudages. Une requête comme « le meilleur SUV pour les longs trajets » ne déclenche pas simplement une recherche de documents. Cela crée une chaîne :

- Identifiez les caractéristiques importantes (autonomie, confort, accès à la recharge).

- Développez les requêtes de comparaison pour voir quelles voitures y correspondent.

- Tirez des passages pertinents qui mentionnent à la fois l'autonomie des véhicules électriques et les caractéristiques de confort.

- Filtrez par intégration utilisateur (sur quoi cet utilisateur clique-t-il habituellement ?).

- Réunissez les réponses pour obtenir une réponse qui ne se contente pas de répertorier les VUS, mais qui explique pourquoi ils s'adaptent.

C'est là que cela devient intéressant : les chaînes de raisonnement peuvent être intra-bande (générées directement dans la sortie du LLM), hors bande (pré-structurées et injectées dans le processus) ou hybrides (un mélange des deux). Cela signifie que les systèmes de Google n'improvisent pas toujours. Parfois, ils travaillent sur une carte logique fixe conçue pour filtrer ce qui constitue une réponse.

Et le raisonnement n'est pas un point de contrôle unique : il est appliqué à presque toutes les étapes du pipeline :

- Classification des requêtes: Des hypothèses sur ce que vous vraiment signifiait.

- Ventilateur: Expansion aux requêtes synthétiques basées sur des objectifs de raisonnement.

- Récupération du corpus: Filtrer selon les types de contenu qui devraient satisfaire à chaque étape du raisonnement.

- Routage des tâches: attribution de différents LLM à des sous-tâches telles que l'extraction, la synthèse ou la synthèse.

- Synthèse finale: Utiliser le raisonnement comme modèle pour construire la réponse.

- Citation: Choisir les passages qui correspondent le mieux aux différentes étapes du raisonnement, pas nécessairement les pages les mieux classées.

L'angle du référencement ? Vous n'écrivez plus pour un système de questions-réponses statique. Vous écrivez pour une machine qui a besoin de passages pour survivre plusieurs couches de raisonnement. C'est une barre plus haute que tout ce que nous avons dû affronter auparavant.

Structurer le contenu pour passer les filtres de raisonnement

Voici la triste vérité : il ne suffit pas d'être « un bon contenu ». Le mode IA n'évalue pas votre site dans son ensemble. Il teste vos passages par rapport à des points de contrôle de la chaîne de raisonnement. Si tu échoues à un match, tu es abandonné.

Alors, comment survivez-vous ? Vous pouvez penser à l'ingénierie de contenu dans quatre piliers.

Adapter à la cible de raisonnement

Chaque passage doit avoir un sens pris isolément. Le système ne lit pas toujours votre page de haut en bas. Il arrache des morceaux. Si votre comparaison entre deux VUS est cachée dans un mur de texte de 1 500 mots, vous êtes invisible.

Écrivez de manière à énoncer les compromis et les choix :

- « La Tesla Model Y offre une plus grande autonomie, tandis que la Ford Mustang Mach-E permet une recharge plus rapide. »

C'est du contenu compatible avec le raisonnement : complet, contextuel et extractible.

Soyez compatible avec Fan-Out

Les requêtes Fan-out sont pilotées par les entités. Si Google génère « meilleur VUS électrique de moins de 60 000 km avec troisième rangée de sièges » et votre page ne dit que « véhicules électriques adaptés aux familles » sans donner le nom à la Kia EV9 ou au Rivian R1S, vous passerez à côté de la solution.

Vous devez commencer votre contenu à l'aide de noms d'entités, de numéros de modèle, de spécifications et de phrases contextuelles qui correspondent directement au Knowledge Graph. Sans ces crochets, l'extension du ventilateur passe juste devant vous.

Soyez digne d'être cité

Google récompense la clarté. Le LLM veut des informations qu'il peut saisir, vérifier et attribuer. Cela signifie :

- Allégations quantitatives

- Sources nommées

- Triples sémantiques (déclarations sujet-prédicat-objet)

Comparez ces deux lignes :

✘ « Le modèle Y est populaire auprès des familles. »

✔ « Le Model Y peut accueillir sept personnes, offre une autonomie de 330 miles et a été le véhicule électrique le plus vendu au monde en 2023 (Statista). »

Un seul d'entre eux est prêt à être cité.

Soyez respectueux de la composition

Le mode IA ne réécrit pas votre prose, il assemble des passages. Cela signifie que votre structure compte autant que votre langue. Les listes, les paragraphes comportant la première réponse et les sections modulaires sont vos amis. Si votre écriture peut être divisée en différentes formes de réponses (graphiques, puces, listes), vous augmentez vos chances de réutilisation.

Il ne s'agit pas de « rédiger un article ». Il s'agit de passages techniques pour la recomposition des machines. Et si cela semble étranger, c'est parce que ça l'est. Le SEO vient de devenir une architecture de contenu.

Stratégies de classement matriciel pour le mode IA

Le suivi des classements classique est mort ici. Vous n'êtes pas en compétition pour « un poste ». Vous participez à une matrice de requêtes synthétiques, de vérifications de passage et d'intégration de scores. Pour gagner, il faut franchir autant d'étapes de raisonnement que possible.

Comment travaillez-vous dans cet environnement ? Décomposons-le.

Étape 1 : Extraire le classement des fans

Intégrez les requêtes synthétiques de Qforia dans un outil de suivi des mots clés. Cartographiez celles pour lesquelles vous apparaissez actuellement et celles qui appartiennent à vos concurrents.

Étape 2 : Générer des intégrations de passages

Prenez vos pages, divisez-les en passages et vectorisez-les. Vous essayez de reproduire l'indexation des passages de Google.

Étape 3 : Comparaison avec les citations

Trouvez les passages que le mode IA cite réellement. Vectorisez-les également. Comparez maintenant la similitude des cosinus. Où êtes-vous aligné ? Où êtes-vous à des kilomètres ?

Étape 4 : Corrigez les lacunes

Une faible similitude signifie que votre contenu ne « pense pas dans la bonne langue ». Corrigez cela avec :

- Chiffres et réclamations

- Mentions d'entités

- Phrase comparative

- Découpage sémantique plus clair

Étape 5 : Traiter les clusters comme des matrices

Parfois, une méga-page peut gérer toutes les sous-requêtes. D'autres fois, vous aurez besoin de plusieurs pages reliées entre elles. Laissons les données décider. Les clusters thématiques ne sont plus une préférence éditoriale, mais des matrices pilotées par le mode IA. Vous n'optimisez plus une page pour un mot clé. Vous créez un réseau de passages qui peuvent croiser des chaînes de raisonnement dans le plus grand nombre d'endroits possible.

Explication du mode Rethinking : comment fonctionne le mode AI

Soyons francs : le mode IA n'est pas une fonction de recherche telle que vous la connaissiez. Ce n'est pas une chaîne de performance. C'est une couche de visibilité probabiliste. Cela signifie qu'avant de plonger, vous devez vous poser les questions suivantes : tu veux même participer à une compétition ici ?

Pourquoi ? Parce que trois quarts de travail changent la donne.

- Le trafic n'est pas le résultat : Les taux de clics sont en train de chuter. Votre récompense peut être une mention ou une citation de la marque, et non une visite. Si vous recherchez des conversions, le mode IA vous frustrera.

- Le contenu devient ingénierie : Vous n'écrivez pas des articles de blog, vous produisez des passages consommables par machine. Cela nécessite de nouveaux flux de travail, de nouvelles normes éditoriales et un état d'esprit plus proche de la science des données que de la rédaction.

- Le référencement devient une stratégie de pertinence : Vous ne pouvez plus simplement optimiser pour les mots clés. Vous devrez concevoir l'alignement avec les intégrations, les points de contrôle du raisonnement et les couches de personnalisation. C'est une toute nouvelle discipline.

Voici donc la vraie question :

- Si vous jouez pour un retour sur investissement en réponse directe, ignorez peut-être le mode IA. Respectez les SERP classiques.

- Mais si votre objectif est la présence, la confiance et la visibilité, si vous voulez que votre marque soit intégrée au raisonnement automatique, vous devrez faire appel à une ingénierie pour y parvenir.

Il n'y a pas de juste milieu. Le mode AI n'est pas « une autre fonctionnalité SERP ». C'est une autre chaîne. Soit tu joues à son jeu, soit tu ne joues pas.

Les nouvelles exigences logicielles de référencement pour AI Surfaces

Si vous voulez survivre en mode IA, vous aurez besoin d'outils qui comprennent les intégrations, simulent le fan-out, suivent les chaînes de raisonnement et personnalisent les modèles. Cela n'existe pas encore à grande échelle. Ce qui signifie deux choses :

- Vous êtes obligé de le pirater avec un code personnalisé, des abonnements Clickstream et une automatisation du navigateur.

- Vous devriez commencer à exiger davantage de vos fournisseurs de logiciels.

Mesure de la recherche par IA dans la console de recherche Google

Commençons par le propre outil de Google. La Search Console devrait être notre fenêtre sur la façon dont nous apparaissons, mais ce n'est pas le cas. Les rapports sont plafonnés, les données semblent assainies et des surfaces entières (aperçus de l'IA et mode IA) sont invisibles. À l'heure actuelle, tout le trafic que vous recevez en mode IA s'affiche sous la forme Directement à cause d'une balise noreferrer. Cela signifie que votre canal de recherche le plus important est essentiellement incommensurable.

Ce dont nous avons besoin :

- Rapports de surface d'IA dédiés (aperçu de l'IA, mode IA, etc.).

- Cartes thermiques des citations : quels passages de votre site ont été cités.

- Nombre de fréquences : la fréquence à laquelle vous apparaissez dans les réponses génératives.

Ce que tu peux faire aujourd'hui : vous ne pouvez pas le mesurer nativement. Mais vous pouvez obtenir des réponses génératives à grande échelle avec des outils tels que Profond, ou créez votre propre automatisation de navigateur et des scripts de correspondance de chaînes.

Ce que tu devrais faire demain : remplissez le formulaire de commentaires du GSC et demandez des données de visibilité sur l'IA. Google va traîner les pieds à moins que suffisamment de personnes ne le poussent.

Suivi du classement connecté en fonction des personnages comportementaux

Le suivi des classements traditionnel est un poids mort en mode IA. Les résultats ne sont plus universels, ils sont synthétisés et personnalisés. Ce que vous considérez comme le « rang #3 » peut même ne pas apparaître pour quelqu'un d'autre.

Ce dont nous avons besoin :

- Modélisation des classements qui simule les personnages des utilisateurs.

- Données liées aux classes d'intention, aux extensions de fan out et aux couches de personnalisation.

Ce que tu peux faire aujourd'hui: créez des personnages de test. Créez des comptes Google connectés, simulez un comportement et exécutez vos requêtes via le mode AI avec Operator ou un navigateur sans tête. Comparez ensuite les sorties.

Insertions vectorielles pour le Web

Oubliez la densité des mots clés. Oubliez TF-IDF. La récupération moderne de Google s'effectue sur des intégrations. Les requêtes, les documents, les passages et même les utilisateurs vivent tous dans un espace vectoriel multidimensionnel. Si vous ne savez pas où se trouve votre contenu dans cet espace, vous ne savez pas pourquoi vous êtes ou n'êtes pas consulté.

Ce dont nous avons besoin :

- Explorateur d'intégrations qui révèle les intégrations au niveau du site, de l'auteur et du passage.

- Évaluation de la récupérabilité : dans quelle mesure vos passages correspondent aux requêtes des fans.

- Conseils d'élagage : quel contenu est trop éloigné du sujet pour être important.

Ce que tu peux faire aujourd'hui : Grenouille hurlante peut générer des intégrations, et vous pouvez également pirater des fonctions JS personnalisées.

Données Clickstream

Le trafic du mode AI est pratiquement invisible dans GSC. Et de nombreux résultats génératifs ne génèrent aucun clic. Cela vous permet de voler à l'aveugle, sauf si vous disposez de données comportementales externes.

Ce dont nous avons besoin :

- Intégration de Clickstream dans les outils de référencement.

- Cartographie entre la recherche organique et les surfaces d'IA.

- Modèles de reclassement liés aux clics réels des utilisateurs.

Ce que tu peux faire aujourd'hui : liez les données Clickstream manuellement à l'aide de Site Web similaire ou Données.

Qu'est-ce que QFORIA et comment fonctionne-t-il ?

Si vous avez suivi la piste des brevets liés au mode IA, vous avez probablement déjà vu l'acronyme QFORIA circuler. C'est en fait l'un des éléments les plus importants de la façon dont Google décide ce qu'il faut récupérer, comment raisonner et quelles réponses faire surface.

QFORIA divise la recherche en un pipeline de raisonnement structuré, dans lequel chaque requête est développée, testée, reclassée et synthétisée en fonction de plusieurs couches de raisonnement. Au lieu d'un système de classement unique, QFORIA orchestre l'ensemble du processus de requêtes en éventail, de récupération de passages et de synthèse basée sur des modèles.

Ce que signifie QFORIA

QFORIA signifie :

- Requête — l'entrée utilisateur d'origine (saisie, parlée ou multimodale).

- Ventilateur — l'extension de cette requête en plusieurs sous-requêtes (explicites, implicites, comparatives, personnalisées).

- Raisonnement — Étapes de synthèse basées sur le LLM qui interprètent, enchaînent et recombinent des passages.

- Inférence — intégration de l'alignement, de la personnalisation contextuelle et de la sélection des réponses « candidates ».

- Agrégation — fusion et reclassement des passages, des citations et des résultats dans une réponse finale cohérente.

Il s'agit d'un flux de travail empilé qui régit le mode IA depuis le moment où vous posez une question jusqu'à la seconde où il produit une réponse multimodale.

Comment QFORIA façonne la récupération

C'est là que cela devient intéressant : QFORIA ne se contente pas d'étendre les requêtes. Il utilise des intégrations, des modèles de clics et des signaux contextuels pour décider quelles requêtes de fans sont plus importantes que les autres.

- Si vous effectuez une recherche « les meilleures chaussures de course pour pieds plats », QFORIA peut générer :

- Connexe : « chaussures de stabilité pour coureurs »

- Comparatif : « Chaussures de course Nike vs Brooks Stability »

- Implicite : « des chaussures pour prévenir les blessures dues à la pronation »

- Personnalisé : « les meilleures chaussures de course disponibles près de New York »

Chacun d'entre eux est noté pour sa pertinence et sa récupérabilité dans l'espace vectoriel. Les sous-requêtes les mieux classées déterminent quels passages sont extraits dans le groupe de candidats.

Vous n'êtes donc pas en compétition pour un seul mot clé, mais pour un réseau de sous-requêtes QFORIA cachées auxquelles votre contenu peut correspondre ou non.

QFORIA et couches de raisonnement

Là où QFORIA brille vraiment, c'est dans la phase de raisonnement. Une fois que les passages candidats sont récupérés, ils ne sont pas simplement empilés et classés comme les SERP à l'ancienne. Au lieu de cela :

- Les passages sont regroupés par intention et par contexte.

- Les LLM enchaînent leurs raisonnements (pensez : « d'abord, identifiez les caractéristiques des chaussures de stabilité, puis comparez les différentes marques, puis synthétisez une recommandation »).

- Les conflits ou les ambiguïtés sont résolus par le biais de requêtes supplémentaires.

Le résultat final ? Une réponse fluide et synthétisée qui semble conversationnelle mais qui est en fait le produit de dizaines d'étapes de raisonnement invisibles.

Ce que cela signifie pour le référencement

QFORIA change la donne en matière d'optimisation de trois manières majeures :

- Vous optimisez pour une constellation de requêtes, pas pour un mot clé. Si votre contenu ne correspond pas à l'espace de diffusion masqué, vous ne figurerez même pas dans la liste des candidats.

- L'ingénierie au niveau du passage n'est pas négociable. Les pages entières n'ont pas autant d'importance que le fait qu'un passage spécifique de votre contenu soit récupérable, dense et facile à raisonner.

- La pertinence est probabiliste et non déterministe. Votre inclusion dépend de la façon dont votre contenu s'aligne sur plusieurs sous-requêtes masquées, et pas uniquement sur le terme principal.

Le plat à emporter sur QFORIA

QFORIA est le nouveau « moteur sous le capot » de Google pour le mode IA. Il ne s'agit pas seulement de classement, mais d'orchestration : extension, raisonnement et agrégation des différentes dimensions d'une requête.

Pour les référenceurs, cela signifie que le véritable défi n'est pas « comment puis-je me classer ? » mais « comment concevoir un contenu qui survit au raisonnement multicouche de QFORIA tout en restant cité ? »

C'est difficile, mais cela signifie également que la visibilité n'est pas limitée à un seul mot clé. Si vos passages sont riches sur le plan sémantique, qu'ils correspondent aux types d'intention et qu'ils peuvent être extraits par le biais de requêtes de fan out, vous avez de bonnes chances.

Repenser la recherche de manière stratégique pour l'environnement du mode IA

Le mode IA n'est pas une fonctionnalité. Il s'agit d'une réinitialisation structurelle. La recherche est passée d'une liste de liens familière à un écosystème autonome, conversationnel, multimodal et piloté par la mémoire. L'ancien manuel de référencement, basé sur des requêtes explicites, des classements prévisibles et une attribution basée sur les clics, ne se traduit pas ici.

Pensez à la façon dont les gens utilisent ChatGPT ou Perplexity : des interactions rapides et basées sur la confiance où la réponse apparaît entièrement synthétisée. Pas de clics. Pas de liens bleus. Juste « la réponse ». Le mode IA suit la même voie, mais avec plus de niveaux : personnalisation, intégrations, raisonnement. Cela signifie qu'être visible ici dépend moins de votre classement que de votre situation encodé dans la mémoire du modèle en tant que source digne d'être citée.

Mais soyons réalistes : la première décision est de savoir si vous voulez vraiment jouer à ce jeu. Certaines organisations s'en tiendront à la recherche classique, au marketing de contenu ou aux publicités. Le mode IA ne vaut peut-être pas la peine d'être combattu si le mix de vos chaînes est déjà excellent ailleurs. Mais si tu faire Si vous voulez être compétitif, votre stratégie doit évoluer. Et vite. Ce changement concerne trois domaines principaux : la reclassification des canaux, la transformation des capacités et l'infrastructure de données. Décomposons-les.

Reclasser la recherche en tant que canal de visibilité de l'IA

La recherche organique traditionnelle a toujours été divisée : à la fois performance et image de marque. Environ 70/30. Mais en mode IA, ce ratio est inversé. Vous n'optimisez plus pour le trafic, mais pour la présence.

Pensez-y comme des relations publiques. Votre « placement » consiste à savoir si l'IA vous cite, vous référence ou s'aligne sur vous dans son processus de raisonnement. Et les KPI évoluent en conséquence :

- Part de voix dans les réponses de l'IA (fréquence à laquelle vous apparaissez par rapport à vos concurrents).

- Proéminence des sentiments et des citations (êtes-vous la source principale ou une référence enterrée ?).

- Modélisation d'attribution qui prend en compte l'influence, pas seulement les clics.

Si vous continuez à publier des rapports sur les performances de référencement sur les « classements » et les « sessions organiques », vous ne mesurez pas la bonne chose. Les dirigeants doivent redéfinir les budgets de référencement en tant qu'investissements dans visibilité dans la cognition de l'IA.

Renforcer la pertinence en tant que capacité organisationnelle

Pour gagner en mode IA, il ne s'agit pas de savoir qui peut publier le plus d'articles de blog ou créer le plus grand graphique de liens. Il s'agit de la pertinence de l'ingénierie dans l'espace vectoriel. Cela nécessite de nouveaux muscles :

- Architecture sémantique — Organisez les connaissances de manière à ce qu'elles soient lisibles par machine, recombinables et persistantes. Vous ne vous contentez pas d'écrire des articles, vous créez des unités atomiques d'informations que l'IA peut intégrer dans des chaînes de raisonnement.

- Gouvernance du portefeuille de contenus — Traitez le contenu comme des actifs d'un portfolio. Certains gagnent en pertinence, d'autres se dégradent. Vous devez élaguer, diversifier et optimiser en fonction de la couverture sémantique, et pas seulement du trafic de mots clés.

- Stratégie éditoriale axée sur les modèles — Créez pour deux publics : les humains et les machines. Cela signifie écrire des passages qu'un LLM veut à citer parce qu'ils sont précis, factuels et conformes à l'intégration.

Les organisations avant-gardistes réuniront le référencement, le NLP, le contenu, l'UX, les relations publiques et la science des données dans une seule fonction : l'ingénierie de la pertinence. Il ne suffit plus aux référenceurs de fonctionner en silo : la visibilité du mode IA est trop inégale entre les équipes.

Opérationnalisez l'intelligence dans un monde post-clic

Voici la pilule la plus difficile à avaler : le clic disparaît en tant que signal de mesure. Vous ne pouvez plus dire : « Nous nous sommes classés #1 et avons reçu X visites ». Le mode IA rompt la chaîne entre l'impression, le clic et l'attribution. Alors, comment mesurez-vous ?

Vous avez besoin d'une pile d'informations qui reflète votre position dans le processus de raisonnement du modèle :

- Infrastructure de simulation — Créez des pipelines LLM internes (avec RAG, LLamaIndex, LangChain, etc.) pour simuler la façon dont votre marque apparaît dans les réponses de l'IA.

- Intelligence des citations — Suivez où et pourquoi votre marque est citée sur des surfaces génératives, même si les utilisateurs ne cliquent jamais dessus.

- Intelligence du contenu — Gérez les intégrations au niveau des passages, la présence de graphes de connaissances et la couverture des raisonnements dans les recherches classiques et basées sur l'IA.

Cela signifie des tableaux de bord qui ne se contentent pas d'afficher le « trafic organique », mais « où nous situons-nous dans l'espace latent du modèle ? » Parce que c'est là que réside la confiance aujourd'hui.

De la performance à la participation

La stratégie de recherche évolue de transactions pour participation. Vous ne demandez plus : « Comment sommes-nous classés ? » Vous demandez : « Comment sommes-nous représentés dans la cognition basée sur l'IA ? »

C'est la naissance d'une nouvelle fonction : la stratégie de pertinence. Il s'inscrit dans le cadre de l'ingénierie de pertinence et indique comment votre marque participe aux écosystèmes algorithmiques. Considérez-le comme une orchestration : il s'agit d'aligner le référencement technique, le contenu, les relations publiques et le produit pour garantir que la voix de votre marque soit prise en compte dans le raisonnement automatique. Les organisations qui prospèrent traiteront la visibilité comme un actif stratégique, ce n'est pas un résultat de campagne.

Mais tout le monde ne viendra pas

Soyons francs : toutes les marques ne feront pas ce saut. Certains se tourneront vers les SERP classiques. D'autres ignoreront le mode IA jusqu'à ce qu'il réduise leur visibilité. Et quelques-uns redoubleront d'efforts pour créer des systèmes de connaissances lisibles par machine qui les rendront incontournables dans le domaine de la cognition basée sur l'IA.

C'est là que le champ se divise. Le référencement en tant que « recherche de classement » est en train de prendre fin. Le référencement en tant qu' « ingénierie de pertinence » commence. Ceux qui s'adaptent définiront l'avenir de la visibilité. Ceux qui ne le font pas ? Ils tomberont doucement dans l'obscurité.

Conclusion

La recherche n'est plus un simple échange entre un mot clé et un lien bleu. Le mode IA en a fait un système de raisonnement à plusieurs niveaux, dans lequel le contenu vit ou meurt en fonction de sa capacité à être analysé, réassemblé et cité par les machines.

Si vous optimisez toujours pour les anciennes règles, vous êtes déjà en retard. Vous devez penser moins comme un chasseur de mots clés que comme un ingénieur de pertinence. Cela implique de concevoir des passages, d'anticiper les requêtes synthétiques et de préparer du contenu pour des pipelines de raisonnement qui ne ressemblent en rien aux SERP sur lesquels nous avons grandi.

Vous pouvez continuer à attendre que Google l'épelle, ou vous pouvez créer en fonction de ce qui se passe déjà. L'avenir de la recherche ne réside pas dans les clics, mais dans sa présence au sein de la cognition automatique. La seule vraie question qui reste est de savoir si vous êtes prêt à concourir pour cette place. Alors... tu viens avec nous ?